In vielen Programmiersprachen hat der Programmierer eigentlich gar nichts mehr mit Speicherverwaltung und Bits & Bytes zu tun. Dennoch ist es wichtig, die Hintergründe zu verstehen, denn dadurch lassen sich Fehler vermeiden.

Inhaltsverzeichnis

Zusammenfassung

- Jede Variable wird im Hintergrund binär repräsentiert.

- Ein Bit entspricht einer Ziffer im Binärsystem und kann 0 oder 1 sein.

- Ein Byte besteht aus acht Bits und kann 256 Zustände abbilden.

- Je nach Datentyp können verschiedene Zahlenbereiche oder Zeichensätze dargestellt werden.

- Die Wertigkeit der Bits kann von links nach rechts oder umgekehrt indiziert sein.

- Die Stelle des Bits bildet den Exponenten, und durch die Aufsummierung der Werte erhält man die dezimale Repräsentation.

- Variablen und Speicher werden letztendlich binär repräsentiert, daher ist es wichtig, dies im Hinterkopf zu behalten.

- Es gibt häufige Fragen zu Bits und Bytes, z. B. der Unterschied zwischen Bits und Bytes und die Geschichte der Bits.

- Bits sind die kleinste Einheit in der Computerwelt, und Datenmengen werden oft in Bytes oder größeren Einheiten angegeben.

Das Binärsystem

Jede Variable wird im Hintergrund binär repräsentiert. Um das zu verstehen sollte man sich zunächst mit dem Binärsystem vertraut machen. Ein Bit (“binary digit“) entspricht einer Ziffer im Binärsystem und kann zwei Zustände einnehmen – 0 und 1. Ein Byte besteht aus acht Bits und kann somit 2⁸ Zustände abbilden, also 256. Das ist eine recht geläufige Zahl, denn in der Informatik kommen Zweierpotenzen oft vor. Je nach Datentyp können also zum Beispiel eine Zahl zwischen 0 und 255 oder auch ein UTF-8-kodiertes Zeichen mit einem Byte abgebildet werden. Größere Datentypen erlauben demnach größere Zahlenbereiche oder größere Zeichensätze.

Die Bitwertigkeit

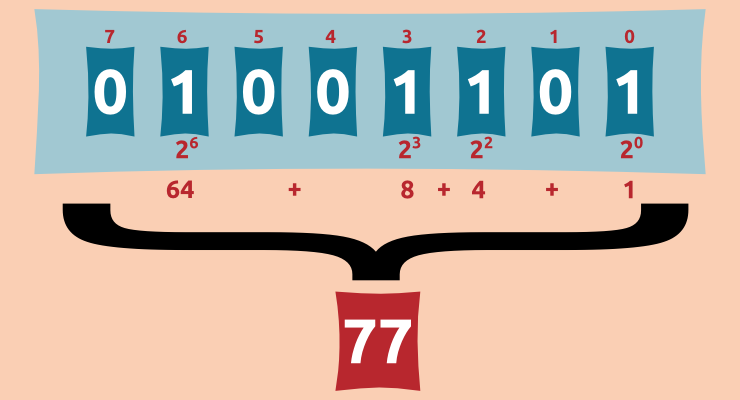

Die Bits die zu einem Byte gehören, können sowohl von links nach rechts als auch umgekehrt indiziert sein. Der Index eines Bits bestimmt dessen Wertigkeit. Wird von links nach rechts durchnummeriert, spricht man von MSB 0 (“most significant bit”), das bedeutet das Bit mit dem höchsten Wert steht ganz rechts. In unserem Beispiel (siehe Bild oben) spricht man von LSB 0 (“least significant bit”), das Bit mit dem niedrigsten Wert steht also ganz rechts. Jedes Bit kann zwei Zustände einnehmen, das ist die Basis der Wertigkeit. Die Stelle des Bits (also der Index) bilden den Exponent. Durch aufsummieren der Werte erhält man die dezimale Repräsentation.

Im Hinterkopf behalten

Um Programmieren zu können ist es nicht unbedingt nötig die Hintergründe und das Binärsystem vollständig zu beherrschen aber man sollte zumindest im Hinterkopf behalten, dass Variablen (und jegliche andere Form von Speicher) im Endeffekt Binär repräsentiert werden. Bei Datenübertragungen über Rechnergrenzen hinweg kann zusätzlich noch die Bitwertigkeit ins Spiel kommen. Im Programmieralltag wird man mit diesen Sachen immer wieder mal in Berührung kommen bis man es dann doch mal als ganz selbstverständlich betrachtet.

Hinweis: Unser Android-Quiz für Informatik enthält neben zahlreichen anderen Informatik Fragen auch Fragen zur Umrechnung von Binärzahlen (in der Kategorie “Grundlagen der Informatik”).

FAQ: Häufige Fragen zu Bits & Bytes

Ein Byte ist 8 Bits lang, während ein Megabit 1 Million Bits (oder 1.000 Kilobits) umfasst. Aber es hängt alles von der Zählung ab. Es kommt darauf an, ob die Zahl binär oder dezimal berechnet wird.

Der englische Begriff “binary number” ist der Ursprung des Begriffs Bit. Er lässt sich ins Deutsche mit “Binärzahl” übersetzen. Als Binärziffer bezeichnet man die kleinste Einheit, die in der Computerwelt verwendet wird. Binäre Ziffern können entweder “0” oder “1” sein.

John W. Tukey, ein US-amerikanischer Mathematiker, schuf den Begriff “Bit”. In einem Bells Lab Memo reduzierte Turkey binäre Informationsziffern auf Bits. Das Wort “Bit” wurde erstmals 1948 von Claude E. Shannon in seinem Aufsatz “A Mathematical Theory of Communication” als Informationseinheit verwendet. Vannevar Bush verwendete den Begriff “Bit” für Wahrheitswerte, die auf Lochkarten für Computer gespeichert wurden.

Bits sind zu klein, um leicht verstanden zu werden. DSL-Unternehmen werben mit Hochgeschwindigkeits-Internetverbindungen von 300 Megabit pro Minute (Mbit/s) und mehr. Da Computer mit großen Datenmengen arbeiten, haben Festplatten und USB-Sticks Speicherkapazitäten, die in Megabyte oder Gigabyte angegeben werden.

Obwohl Programmierer in vielen Programmiersprachen nicht mehr direkt mit Bits und Bytes arbeiten, ist es dennoch wichtig, die Hintergründe zu verstehen, um Fehler zu vermeiden. Variablen und Speicher werden letztendlich binär repräsentiert, daher sollte man dies im Hinterkopf behalten.

Das Binärsystem ist die Basis für die Repräsentation von Informationen in Computern. Es besteht aus den beiden Zuständen 0 und 1, die den Wert eines Bits darstellen. Durch Kombination von Bits können Zahlen, Zeichen und andere Daten dargestellt werden.

Die Wertigkeit von Bits wird durch den Index bestimmt, der den Exponenten bildet. Wenn die Bits von links nach rechts durchnummeriert werden, spricht man von MSB 0 (most significant bit) und wenn sie von rechts nach links durchnummeriert werden, spricht man von LSB 0 (least significant bit).

In der Programmierung werden Variablen und Daten letztendlich binär repräsentiert. Bei der Entwicklung von Algorithmen und der Arbeit mit Speicher ist es wichtig, die Eigenschaften von Bits und Bytes zu verstehen, um effizient und fehlerfrei programmieren zu können.

Bei der Übertragung von Daten über Netzwerke und Rechnergrenzen hinweg kann die Bitwertigkeit eine Rolle spielen. Unterschiedliche Systeme können unterschiedliche Darstellungen und Reihenfolgen von Bits haben, was zu Konvertierungs- und Kompatibilitätsproblemen führen kann.

Je nach Datentyp können verschiedene Zahlenbereiche oder Zeichensätze mit Bits und Bytes dargestellt werden. Kleinere Datentypen erlauben kleinere Zahlenbereiche oder begrenzte Zeichensätze, während größere Datentypen größere Zahlenbereiche oder umfangreichere Zeichensätze ermöglichen.